Mono- und Farbkameras – By Philipp Lechner

Eines der meistdiskutierten Themen in der Hobbyastronomie neben den Fragen „Refraktor oder Reflektor“, „Visuelle Astronomie oder Astrofotografie“ und natürlich „Ist die Erde flach?“, ist die Frage „Monokameras oder Farbkameras“.

Wie bei all diesen Fragen (außer bei einer) gibt es nur eine richtige Antwort: Kommt drauf an.

Ob Mono- oder Farbkamera, jede hat ihre Anwendungsmöglichkeiten, Stärken und Schwächen. Da sich diese aber oft überschneiden, kommt es zu hitzigen Diskussionen, in denen auch viele Mythen und Missverständnisse immer wieder als Argumente gebracht werden.

Ich will hiermit versuchen, diese Mythen, sowie über die Vor- und Nachteile, aber als erstes, über die eigentlichen Unterschiede von Mono- und Farbkameras aufzuklären.

Die Unterschiede

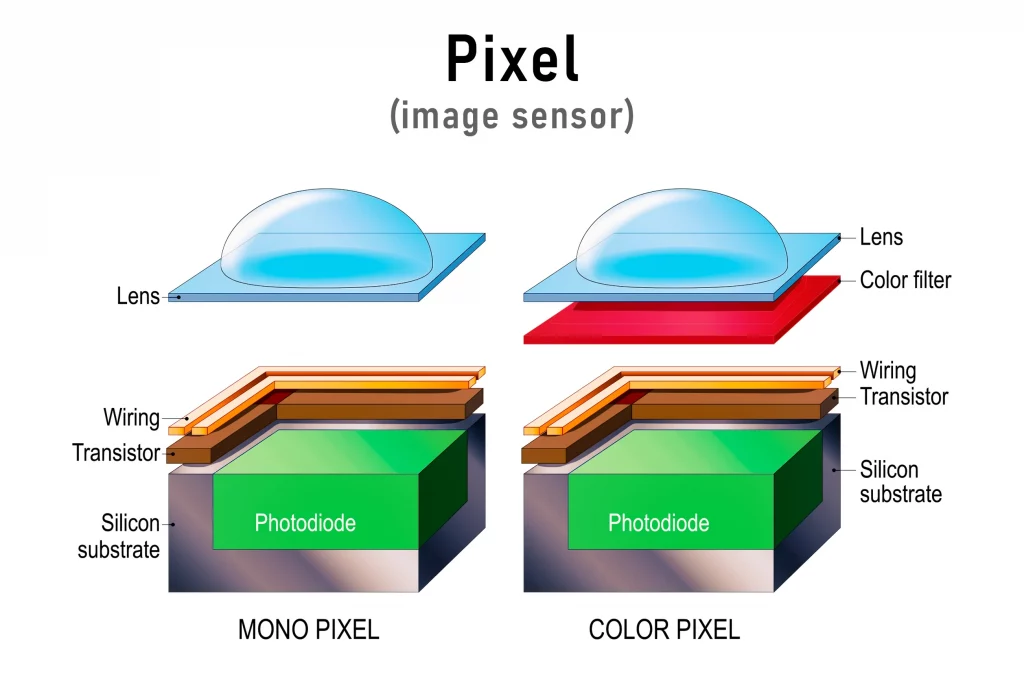

Monochromatische Kameras (von hier an als Monokamera bezeichnet) und Farbkameras (von hier an als OSC, One Shot Camera bezeichnet) unterscheiden sich grundsätzlich weniger, als man annehmen würde. Der einzige Unterschied besteht darin, dass sich bei den Sensoren von Farbkameras zwischen der Photodiode, die Licht in elektrische Spannung umwandelt, und der Mikrolinse, die das Licht auf die Photodiode fokusiert, ein Farbfilter befindet.

https://corial.plasmatherm.com/en/blog/bringing-micro-lenses-into-focus

Es gibt rote, grüne und blaue Filter, die nur rotes grünes oder blaues Licht auf den Sensor fallen lassen. Die Photodioden selbst können nicht zwischen Farben unterscheiden. Könnte man die Farbfilter vom Sensor entfernen, hätte man aus einer Farbkamera eine Monokamera gemacht.

Manche kratzen die Mirkolinsen und Filter vom Sensor, um eine Monokamera zu erhalten (bitte nicht zuhause nachmachen).

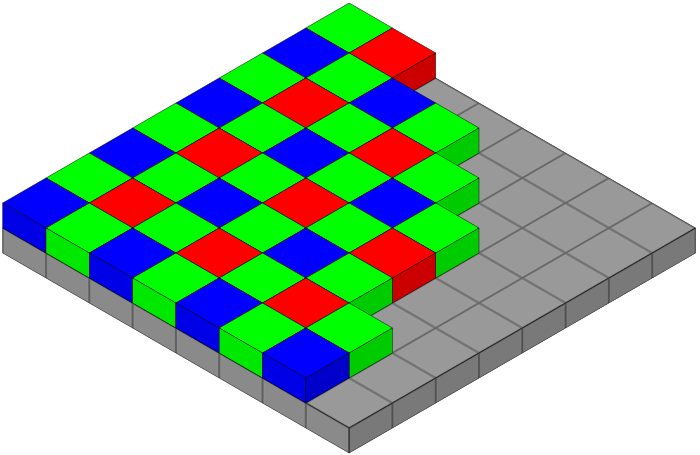

Die Farbfilter auf jedem Pixel werden in einer bestimmten Reihenfolge angeordnet. Die häufigste Anordnung ist Rot, Grün, Grün, Blau. Dies nennt man die Bayer-Matrix (nach dem Erfinder Bryce E. Bayer).

https://commons.wikimedia.org/wiki/File:Bayer_pattern_on_sensor.svg

Somit werden 25% des Sensors von roten Filtern, 25% von blauen und 50% von grünen Filtern bedeckt. Diese Anordnung hat sich bei Farbkameras in der (terrestrischen) Fotografie bewährt und soll die Wahrnehmung des menschlichen Auges imitieren. Warum werden 50% für grünes Licht reserviert, wenn es auch blaues Licht sein könnte?

Der Mensch ist für grünes Licht am empfindlichsten und erkennt daher in grünen Objekten den meisten Kontrast. Hat man sich außerdem jemals in der Natur umgesehen, wird man rasch feststellen können, dass es überraschend viel Grün zu sehen gibt.

Monokameras dagegen haben keine Bayer-Matrix. Rotes, grünes und blaues Licht fällt gleichermaßen auf alle Pixel, wodurch man ein schwarz-weißes Bild erhält.

Trotzdem kann man mit Monokameras beeindruckende Farbbilder erstellen. Dies bewerkstelligt man mit der Nutzung verschiedener Filter, die man vor die Kamera selbst anbringt.

Für Breitbandobjekte wie z.B. Galaxien oder Kugelsternhaufen (dazu später mehr) verwendet man bei Monokameras in der Regel vier Filter. Zum einen rote, grüne und blaue Filter um ein Farbbild zu erhalten, zum anderen einen sogenannten Luminanzfilter, um mehr Kontrast und Daten zu erhalten. Dieser blockiert nur das Licht im Infrarot- und Ultraviolettbereich des Farbspektrums (daher nennt man sie auch UV/IR Cut Filter) und lässt den Rest, ohne Farben zu unterscheiden, passieren.

Der Luminanzfilter

Noch mehr als bei grünem Licht, kann das menschliche Auge Kontrast in Hell und Dunkel wahrnehmen. Da uns der Luminanzfilter nur Informationen darüber liefert, wo ein Objekt hell und wo es dunkel ist, wirkt ein Bild kontrastreicher und damit detailreicher, je mehr Licht man mit einem Luminanzfilter aufnimmt. Typischerweise werden bei Bildern, die mit Monokameras erstellt werden, 50% der Belichtungszeit mit dem Luminanzfilter aufgenommen. Die restlichen 50% werden gleichermaßen für den roten, grünen und blauen Filter verwendet.

Die Möglichkeit, Licht ungehindert (also ohne Farbfilter) in den Sensor eintreten zu lassen, hat eine OSC nicht. Hier wird das Licht immer gefiltert.

Die Effizienz der Filter und Sensoren

Jeder Filter besitzt unterschiedliche Effizienzen bzw. Transmissionsraten, also wie viel gewünschtes Licht der Filter passieren lässt und wie viel unerwünschtes Licht der Filter blockiert. Eine Transmission von 90% bedeuten etwa, dass 90% der Photonen durchgelassen werden und 10% reflektiert werden und somit verloren gehen.

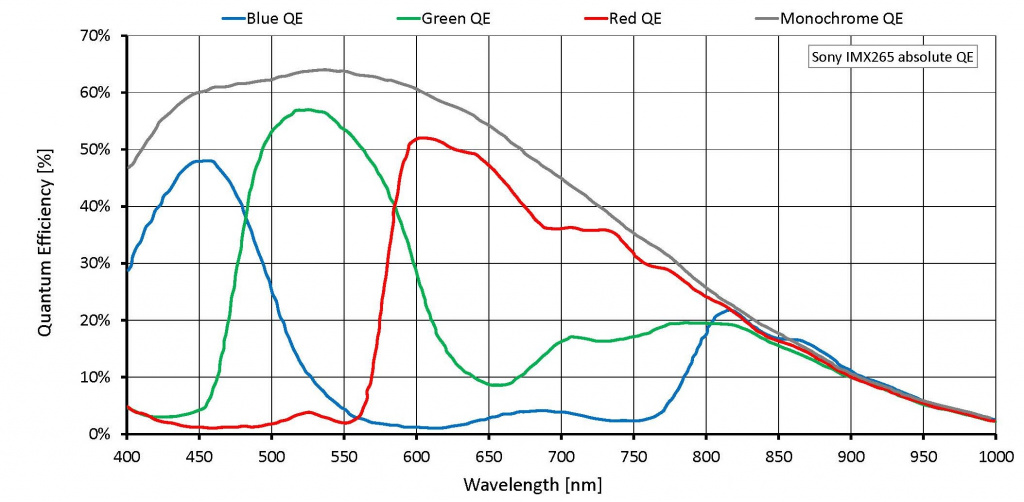

Bei Sensoren bedeutet Quanteneffizienz, wie viele der Photonen in Elektronen umgewandelt werden.

Im unteren Bild sieht man auf der Y-Achse die Quanteneffizienz der jeweiligen Filter eines Farbsensors und in grau die Effizienz der Monovariante des gleichen Sensors (hier Sony IMX265).

https://www.alliedvision.com/en/products/alvium-configurator/alvium-1800-c/319/

Hier sieht man, dass die OSC eine maximale Effizienz von ca. 57% beim grünen Filter aufweist, die Monovariante hingegen eine maximale Effizienz von ca. 64% (moderne Sensoren erreichen bei OSC ein Maximum von 80%, Mono ein Maximum von 91%).

Bei der Quanteneffizienz von 91% eines Monosensors ist jedoch nicht die Transmission der benötigten Filter mit inbegriffen, welche (bei modernen Filtern) bei über 95% liegt.

Gehen wir davon aus, dass 100 Photonen durch einen modernen Filter (Transmission 95%) und dann auf einem modernen Monosensor (QE 91%) landen. Theoretisch werden hier maximal 86 Photonen in Daten umgewandelt.

Fallen die gleichen 100 Photonen auf einen Farbsensor, werden maximal nur 80 Photonen aufgenommen.

Je nach Wellenlänge des einfallenden Lichts unterscheiden sich diese Werte natürlich. Ein Licht, welches die Wellenlänge 656nm besitzt (Hα) wird beim IMX265 Monosensor nur zu ca. 53% umgewandelt. Die Wellenlänge des Lichts sieht man beim obigen Bild auf der Y-Achse

Allgemein kann man sagen, dass Monokameras effizienter als Farbkameras sind.

Die Überschneidung der Filter

Sehen wir uns nochmals das Bild von oben an, kann man eine weitere Eigenheit der OSC erkennen. Die Transmissionen der verschiedenen Filter überschneiden sich.

Empfängt ein Farbsensor beispielsweise ein Licht der Wellenlänge 625nm, was unser Auge als orange wahrnehmen würde, fällt eine große Menge des Lichts durch den roten Filter, eine kleinere Menge wird aber auch durch den grünen Filter durchgelassen. Nimmt man viel rot und mischt ein wenig grün dazu, erhält man orange, also genau das, was auch ein Auge wahrnehmen würde.

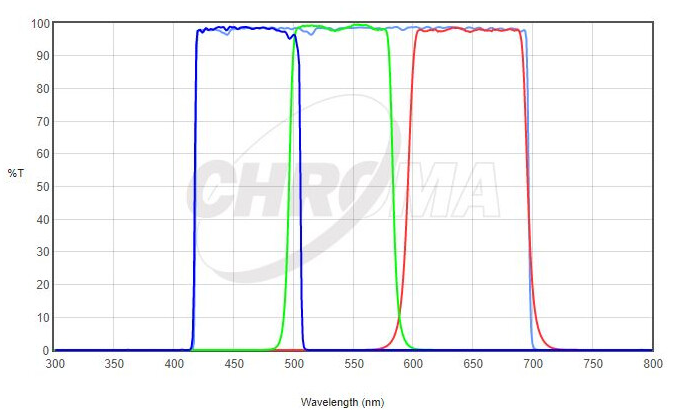

https://www.astroshop.de/l-rgb-filter/chroma-filter-lrgb-set-36mm/p,70691

Oben sieht man die typischen Transmissionskurven eines Filtersets für Monokameras.

Wird das Licht mit 625nm hintereinander erst von einem roten, dann einem grünen und schließlich einem blauen Filter bei einer Monokamera aufgenommen, wird nur der rote Filter das Licht durchlassen und somit als rot interpretiert. Die Information, dass das Licht eigentlich orange ist, geht bei einer Monokamera verloren. Gelb-Oranges Licht mit der Wellenlänge von ca. 590nm würde durch die Farbfilter gar nicht aufgenommen werden.

Die Filter weisen deswegen dort eine Lücke auf, damit das Licht von Natriumdampflampen, die früher als Straßenlampen verwendet wurden, nicht aufgenommen wird.

Filter der Firma Astronomik weisen zwar auch Überschneidungen auf, imitieren die Wahrnehmung des menschlichen Auges aber nicht so gut wie die Filter in Farbsensoren.

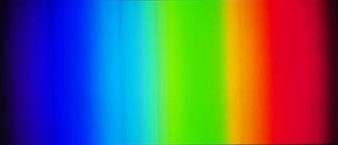

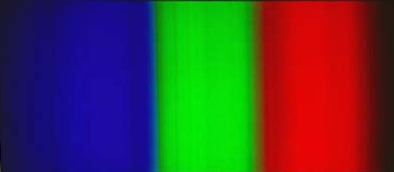

Sehr anschaulich sieht man die Unterschiede, wenn man das volle Spektrum mit einer Farbkamera (oben) und einer Monokamera (unten) aufnimmt.

Cloudynights – Loss of color diversity in LRGB photography when the filters do not overlap

https://www.cloudynights.com/topic/867680-loss-of-color-diversity-in-lrgb-photography-when-the-filters-do-not-overlap/

Diese Unterschiede sind zugegebenermaßen ausschlaggebender in terrestrischer Fotografie, sollten aber nicht außer Acht gelassen werden.

Breitband- und Schmalbandobjekte am Himmel und auf der Erde

Unter Breitbandobjekte fallen Objekte deren Licht einen Großteil des Farbspektrums einnehmen. Dies sind z.B. Sterne (wie auch unsere eigene Sonne), Kugelsternhaufen, Galaxien und Reflexionsnebel, wobei Reflexionsnebel im Grunde Sternenlicht ist, welches einen Nebel erhellt.

Auf der Erde geben z.B. LED Lampen ein breites Farbspektrum an Licht ab.

Mit einer OSC nimmt man Breitbandobjekte folgendermaßen auf: draufhalten und abdrücken.

Mit einer Monokamera verwendet man nacheinander die vorhin erwähnten LRGB Filter (manchmal auch Hα z.B. bei Galaxien)

Schmalbandobjekte hingegen geben ihr Licht hauptsächlich in einem schmalen Spektrum, also nur in bestimmten Wellenlängen ab. Dies sind Emisionsnebel, die, im Gegensatz zu Reflexionsnebel, nicht das Licht von Sternen streuen, sondern die Elemente des Nebels selbst emittieren Licht. Auch planetarische Nebel und Supernovaüberreste zählen zu dieser Gruppe.

Auf der Erde geben Natriumdampflampen oder rote, grüne und blaue Laserpointer Licht in einem schmalen Spektrum ab.

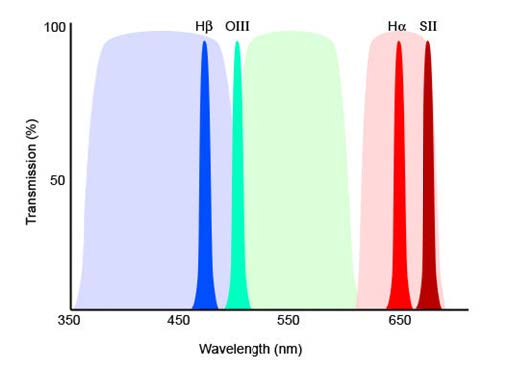

Die drei wichtigsten Elemente in der Schmalband-Astrofotografie geben Licht in folgenden Wellenlängen ab:

OIII (zweifach ionisierter Sauerstoff) bei 501nm, welches grün-blau erscheint.

Hα (angeregter, nicht ionisierter Wasserstoff) bei 656nm, welches rot erscheint.

SII (einfach ionisierter Schwefel) bei 672nm, welches tief rot erscheint.

https://starizona.com/blogs/tutorials/narrowband-imaging

Da diese Elemente nur in diesen spezifischen Wellenlängen Licht abgeben, versucht man mithilfe von Filtern das restliche Licht abzublocken.

Je mehr vom restlichen Spektrum durch diese Filter abgeblockt wird, desto mehr Lichtverschmutzung kann vermieden werden. Mit Schmalbandfiltern kann man beispielsweise sogar in einer Großstadt mit viel Lichtverschmutzung oder bei Vollmond Fotos machen.

Je „schmaler“ der Filter, also je weniger nicht erwünschtes Licht er durchlässt, desto teurer ist der Filter.

Typischerweise werden Schmalband Filter als 7nm oder 3nm angeboten. Bei einem 3nm Filter wird beispielsweise nur Licht zwischen 654,5nm und 657,5nm durchgelassen, um Hα-Licht einzufangen.

Um Schmalbandobjekte mit einer Monokamera zu fotografieren, benutzt man SII-Filter, Hα-Filter und OIII-Filter.

Mit einer OSC empfiehlt es sich, sogenannte Dual Band Filter zu benutzen, wie den Optolong L–eXtreme, der nur Hα und OIII passieren lässt. Mit dem Askar Colour Magic kann man OIII und SII gleichzeitig fotografieren.

Die Hubble Palette

Bearbeitet man Schmalbandfotos, die mit einer Monokamera aufgenommen wurden, beginnt man mit drei verschiedenen schwarz-weiß Bildern. Eines zeigt nur SII-Licht, eines nur Hα-Licht und eines nur OIII-Licht. Würde man diese Bilder naturgetreu einfärben und dann übereinanderlegen, hätte man ein Bild welches nur grünliche (OIII) und rote (Hα und SII) Farben hätte, was zwar näher an der Realität wäre, optisch aber nicht sehr beeindruckend aussähe und wissenschaftlich nicht viel Aussagekraft besäße, da man schwer zwischen den beiden Rottönen unterscheiden könnte.

Daher werden solche Schmalbandbilder oft in Falschfarben dargestellt. Die populärste dieser Darstellungsweisen ist die Hubble Palette, welche als erstes beim berühmten Bild des Adlernebels angewandt wurde – Die Säulen der Schöpfung. Dabei wurde OIII blau dargestellt, Hα grün und SII rot. So kann man die Regionen unterschiedlicher Elemente leichter unterscheiden.

Diese Hubble Palette kann man auch bei OSC erreichen, indem man die oben erwähnten Dual Band Filter verwendet. Bei den Fotos, die mit einem Hα/OIII-Filter aufgenommen wurden, fällt das gesamte Hα-Licht nur auf die Pixel mit einem roten Filter, während das gesamte OIII-Licht nur auf grüne und blaue Pixel fällt (Durch die Überschneidung der Filter fällt ein geringer Prozentsatz von Hα auf grüne und blaue Pixel, ein geringer Prozentsatz von OIII fällt auf rote Pixel). Bei der Bearbeitung kann man die Farbkanäle spalten und erhält so ein Hα Bild und ein OIII Bild. Bei der Verwendung eines SII/OIII-Filters erhält man im roten Kanal nun SII und nochmals OIII im grünen und blauen Kanal. Die beiden OIII Bilder kann man erneut stacken. So erhält man wie mit der Monokamera drei verschiedene Bilder, wobei jedes nur ein Element enthält und kann somit ebenfalls ein Bild mit der Hubble Palette erstellen.

Viele Benutzer einer Farbkamera sparen sich den Mehraufwand um SII zu bekommen und erstellen HOO Bilder, welche nur zwei Farben haben.

Somit währen nun alle Unterschiede zwischen Monokameras und Farbkameras besprochen. Kommen wir zu den Vor- und Nachteilen der jeweiligen Kameras. Hauptaugenmerk liegt hierbei auf Astro-Kameras, obwohl viele Argumente auch für DSLR zutreffen.

Kosten

Bei einem ohnehin schon teuren Hobby sind Kosten mitunter einer der wichtigsten Aspekte, die es zu erwägen gilt. Ohne Zweifel sind Monokameras der teurere Weg, den man einschlagen kann. Zum einen sind Monokameras im Vergleich zu Farbkameras teurer. Als Beispiel nehmen wir die beliebte ASI2600 der Firma ZWO, mit einem IMX571 Sensor von Sony. Die Farbvariante (ASI2600MC-P) kostet beim Hersteller $1.499, die Monovariante hingegen (ASI2600MM-P) $1.999, ein Preisunterschied von $500. Bei einem österreichischen Händler kostet die Farbvariante €2.499 und die Monovariante €3.211, also sogar ein Preisunterschied von €712.

Der Grund, dass Monosensoren mehr kosten, obwohl eigentlich weniger drinnen steckt, ist, dass einfach mehr Farbsensoren hergestellt werden. Der Markt für Farbkameras ist größer, die Anwendungsgebiete vielfältiger. Hingegen werden Monosensoren nur in sehr speziellen Gebieten, wie Astrofotografie, eingesetzt, dessen Marktanteil einfach viel kleiner ist. Doch nicht nur die Kameras selbst sind bei der Monofotografie teurer. Man darf nicht das benötigte Zubehör vergessen.

Für Monokameras benötigt man LRGB Filter. Je nach Hersteller, Qualität und die Größe des Filters (meist 1,25″ oder 2″) können diese zwischen €200 und €2.000 kosten. Farbkameras benötigen diese Filter nicht. Will man Schmalbandaufnahmen machen, benötigen Monokameras SHO Filter. Hier kann ein einzelner Filter bereits bis zu €1.500 kosten. Bei Farbkameras kann man Dual Band Filter verwenden. Der Optolong L-eXtreme kostet €330.

Da man für Monokameras normalerweise sieben unterschiedliche Filter verwendet, empfiehlt sich ein elektronisches Filterrad, welches computergesteuert wird und die unterschiedlichen Filter vor die Kamera rotiert. Ein Filterrad mit sieben Positionen kann zwischen €200 und €600 kosten. Für Farbkameras verwendet man normalerweise ein bis drei unterschiedliche Filter. Auch hier kann man ein elektronisches Filterrad verwenden. Da man diese in einer Aufnahmenacht aber typischerweise nicht wechselt, reicht meist eine Filterschublade, bei der man den Filter manuell aus der Schublade zieht und einen anderen einsetzen kann. Diese kosten zwischen €100 und €200.

Aus Gründen, auf die bei Zeit näher eingegangen wird, empfiehlt es sich einen Fokussiermotor einzusetzen. Erwartungsgemäß bringt ein solcher Motor ein Teleskop zurück in den Fokus, falls sich dieser während der Nacht wegen Temperaturschwankungen ändert. Dieser kann zwischen €130 und €330 kosten. Fokussiermotoren werden auch oft bei Farbkameras eingesetzt, sind für Monokameras aber beinahe unumgänglich.

Wie man sehen kann, können sich die Kosten verdoppeln oder sogar verdreifachen, sollte man sich für eine Monokamera entscheiden. Da die Preise der Verkäufer variieren und je nach Hersteller oft keine Grenzen nach oben gesetzt sind, wurden hier ungefähre Werte angenommen, mit denen man rechnen kann.

Zeit

Um das Thema Zeit ranken sich wohl die meisten Mythen. Die häufigsten sind folgende:

„Da man bei Monokameras vier Filter benutzen muss, braucht man viermal mehr Zeit als mit einer Farbkamera.“

„Weil ich nicht viel Zeit unter dem Sternenhimmel habe, benutze ich eine Farbkamera. Weil man alle drei Farben auf einmal fotografiert, bin ich viel schneller.“

Doch die Mythen gehen auch in die andere Richtung:

„Da ich mit einer Monokamera 100% des Sensors für z.B. Rot benutze, bei Farbkameras jedoch nur 25%, bin ich mit einer Monokamera viermal schneller.“

Beides ist falsch. Warum, erklärt sich anhand eines einfachen Rechenbeispiels. Nehmen wir an, alle Filter haben eine Quanteneffizienz von 100% und einem stehen 3 Zeiteinheiten zur Verfügung, welche insgesamt 3000 Photonen auf den Sensor fallen lassen. Person A nimmt mit einer Farbkamera durchgehend auf und erhält 750 rote Photonen, 1500 grüne Photonen und 750 blaue Photonen. Person B mit einer Monokamera verzichtet auf den Luminanzfilter und nimmt nur mit RGB Filter auf. Person B erhält 1000 rote, 1000 grüne und 1000 blaue Photonen. Beide Personen benutzen stetig 100% ihres Sensors und erhalten insgesamt alle 3000 Photonen, nur sind die Farben bei der Monokamera gleichmäßig aufgeteilt.

Mit diesem Beispiel sieht man, dass weder die Mono- noch die Farbkamera viermal schneller ist.

Diese Milchmädchenrechnung geht aber nicht ganz auf, da die Realität etwas komplizierter ist.

Die Effizienzen der Farbkameras sind generell schlechter als bei Monokameras. Dadurch gehen bei Farbkameras mehr Photonen verloren. Bei vielen Emissionsnebeln dominieren rote Photonen. Da Farbkameras im Vergleich zu Monokameras pro Zeiteinheit weniger rote Photonen auffangen können, bedeutet das, dass man mit einer Farbkamera mehr Zeit investieren muss, um auf die gleiche Anzahl an roten Photonen zu kommen. Im Beispiel verzichtet man außerdem auf den Luminanzfilter. Würde man je 0,5 Zeiteinheiten für RGB und die restlichen 1,5 Zeiteinheiten für den Luminanzfilter verwenden, würde das Ergebnis schärfer und kontrastreicher wirken, zum Preis der Farbtreue. Bei einer Monokamera kann man selbst wählen, was einem wichtiger ist, bei einer Farbkamera hat man diese Möglichkeit nicht.

Auf dem beliebten Astronomie-Forum cloudynights.com wurde ein Thread erstellt, der sich dieser Problematik genauer widmet, als ich es je könnte. Der Titel ist „Monochrome vs One-Shot-Color – By The Numbers Please“ (Monochrom gegen Farbe – in Zahlen, bitte).

Der Ersteller kam zu folgenden Ergebnissen:

Nimmt man mit der Monokamera nur RGB Daten auf, kann die Farbkamera in der gleichen Zeit 1,33 mal mehr Photonen sammeln als die Monokamera.

Nimmt man mit der Monokamera gleich verteilt LRGB Daten auf, sammelt die Monokamera 1,174 mal mehr Photonen als die Farbkamera.

Je mehr Zeit man für den Luminanzfilter verwendet, desto schlechter steht es für die Farbkamera. Verwendet man 9 Zeiteinheiten für Luminanz und eine Zeiteinheit für RGB, kann man mit der Monokamera um 2,28 mal mehr Photonen auffangen.

Unter folgendem Link kann man sich die Diskussion selbst durchlesen:

Auch bei Schmalbandaufnahmen punkten Monokameras, was Zeit anbelangt.

Oft will man die gleiche Anzahl an Hα, SII und OIII Licht aufnehmen. Mit einem Dual Band Filter auf einer OSC wird aber immer dreimal soviel OIII als Hα aufgenommen. Will man jedoch eine Stunde mehr Hα Daten haben, nimmt man mit einer Monokamera einfach eine Stunde mit einem Hα Filter auf. Da bei einem Farbsensor nur 25% des Sensors Hα Licht aufnehmen kann, benötigt man die vierfache Zeit, um zum gleichen Ergebnis zu kommen. Das gleiche Prinzip gilt bei einem OIII/SII Filter. Die 75%, die für OIII aufgenommen werden, gehen natürlich nicht verloren, sind aber möglicherweise nicht sehr hilfreich, will man in einer Nacht mit Mond aufnehmen.

Kurz als Erklärung: Der Mond reflektiert Sonnenlicht, welches breitbandiges Licht ist. Man kann es mit Filtern also nicht komplett vom Sensor fernhalten. Da das meiste Licht jedoch abgeblockt wird, sind Aufnahmen in einer Mondnacht möglich. Oft ist das OIII Signal eines Objekts jedoch sehr schwach und wird von Mondlicht überschattet. Hα Signale sind oft viel kräftiger und der Einfluss von Mondlicht kleiner. Immer gilt jedoch: je weiter das Objekt, das man fotografieren will, vom Mond entfernt ist, desto besser.

Anstatt bei einer Mondnacht also OIII aufzunehmen, kann man mit einer Monokamera diese Nächte komplett für Hα verwenden. Mit einer Farbkamera hat man keine Wahl, es wird immer beides aufgenommen.

Ein häufiges Argument, das für OSC spricht, ist, dass man in einer einzigen Nacht ein komplettes Farbbild bekommt. Mit einer Monokamera kann es passieren, dass man zuerst Bilder mit dem roten und dem grünen Filter macht, bevor man aber die Chance hat, den blauen Filter zu verwenden, ziehen Wolken auf, und man muss bis zur nächsten klaren Nacht warten, um ein vollständiges Farbild zu erhalten. Eventuell kann diese klare Nacht auf sich warten lassen und so kann es passieren, dass das Objekt, welches man fotografieren wollte, bis zum nächsten Jahr nicht mehr über dem Horizont erscheint.

Um dies zu verhindern, kann man die Filter während der Nacht öfters wechseln. So könnte man beispielsweise eine Abfolge erstellen, die 15 Aufnahmen mit dem L-Filter und nacheinander 5 mit dem R, G und B-Filter macht. Vielleicht sogar eine Abfolge mit LLLRGB. Mit dieser Taktik verhindert man ein unvollständiges Bild, verliert aber auch mehr Zeit. Das Wechseln des Filters mit einem elektronischen Filterrad dauert ein paar Sekunden. Da jeder Filter in Kombination mit dem Teleskop einen unterschiedlichen Fokus besitzt (selbst, wenn die Filter als „parfokal“ bezeichnet werden), sollte nach jedem Filterwechsel eine Autofokus Routine ausgeführt werden (besitzt man einen Fokusiermotor), was wiederum mehrere Minuten dauern kann.

Bei einer OSC sollte man bei Temperaturschwankungen den Fokus kontrollieren, ansonsten sollte der Fokus jedoch gleich bleiben.

Da der Fokus bei den verschiedenen Filtern unterschiedlich ist, muss man bei Monokameras für jeden Filter Flatframes erstellen, die dann zur Kalibrierung der Bilder verwendet werden. Auf Darkframes bzw. Darkflats bzw. Biasframes haben die Filter keinen Einfluss. Mit einer OSC muss man nur einmal Flatframes erstellen, die, wie viele finden, die aufwändigste Art der Kalibrierungsbilder sind.

Da man die Bilder für jeden Filter registrieren und stacken muss, ist der Zeitaufwand bei der Vorbearbeitung der Bilder bei Monokameras höher. Bei OSC muss man diesen Prozess für alle Bilder nur einmal ausführen.

Der Zeitaufwand bei der Bearbeitung des gestackten Bildes bzw. Bilder macht zwischen Mono und Farbe keinen großen Unterschied oder ist sehr subjektiv. Da die Bearbeitungsschritte sehr unterschiedlich sind, sollte man hier beide Varianten ausprobieren und sehen, welche Bearbeitungsweise einem mehr Spaß macht, als auf den Zeitaufwand zu achten.

Auflösung

Man könnte meinen, es macht keinen Unterschied, ob man mit einer 26 Megapixel Kamera in Farbe oder Mono aufnimmt, da beide Bilder eine Auflösung 26 Megapixel haben werden, was auch stimmt. Die Farbauflösung unterscheidet sich aber zwischen den beiden Arten. Um zu verstehen warum, müssen wir zuerst den Debayering Prozess kennenlernen.

Da die Photodioden im Sensor nicht zwischen Farben unterscheiden können, sind Bilder im Rohformat immer schwarz-weiß, egal ob sie mit einer Mono- oder Farbkamera aufgenommen wurden.

https://commons.wikimedia.org/wiki/File:Colorful_spring_garden_Bayer_%2B_RGB.png

Im ersten Bild sieht man die originale Szene, die wir fotografieren wollen. Das zweite Bild zeigt die rohen Bilddaten, also im RAW Format. Weiß der Computer, in welcher Anordnung die Bayer-Matrix hatte (z.B. RGGB), kann man den Pixel mit der entsprechenden Farbe einfärben, was man im dritten Bild sieht. Da aber jeder Pixel nur entweder einen roten, einen grünen oder einen blauen Filter hat, ist auch im Bild jeder Pixel entweder rot, grün oder blau. So sieht man, dass bei der roten Tulpe nur die roten Filter Licht auf den Sensor fallen ließen, die grünen und blauen Pixel sind schwarz, da dort kein Licht an den Sensor gelang. Bei der gelben Tulpe hingegen fiel nur Licht durch die roten und grünen Filter. Die blauen Pixel bleiben schwarz, da das gelbe Licht der Tulpe nur von den roten und grünen Filtern durchgelassen wurde.

Solch ein Bild gibt aber die Realität nicht sonderlich gut wieder. Um ein akkurates Abbild der Wirklichkeit zu erhalten, muss der Computer „raten“ welche Farben die Pixel haben, die keine Informationen erhalten haben. Erhielten z.B. nur die roten Pixel Informationen, die Pixel in der Nähe jedoch gar keine, kann man davon ausgehen, dass es sich um ein rotes Objekt handelt. Erhalten nur die roten und grünen Pixel Informationen, handelt es sich wohl um ein gelbes Objekt. Fiel das meiste Licht durch die roten Filter, weniger aber durch die grünen Filter, ist das Objekt in Wirklichkeit eher orange als gelb. Diesen Prozess nennt man Debayering oder Demosaicing.

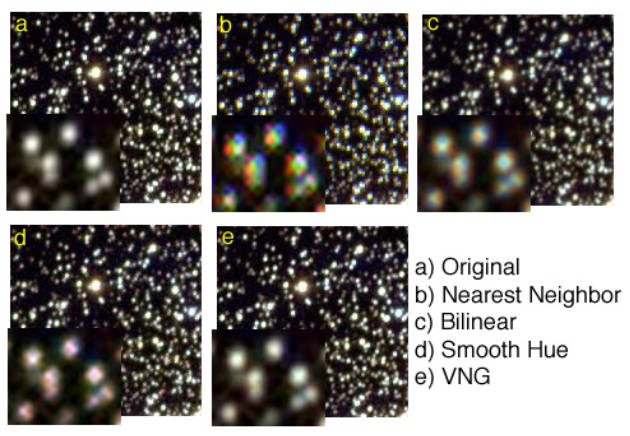

Es können verschiedene Algorithmen angewandt werden, um die fehlenden Informationen zu interpolieren. Wie diese Algorithmen genau funktionieren, sprengt den Rahmen dieses Artikels. Generell kann man jedoch sagen, je genauer der Algorithmus es schafft, die Wirklichkeit zu reproduzieren, desto rechenintensiver und damit länger ist der Prozess für den Computer. Hier sieht man einige Beispiele für typische Algorithmen, die im Debayering-Prozess angewandt werden:

https://www.samys.com/images/pdf/Debayering_API.pdf

Dieser Prozess wird bei Monobildern nicht benötigt. Hier weiß man bei jedem Pixel, wie viel Rot-, Grün- oder Blauanteil es hat. Bei Farbbildern hat man bei jedem Pixel nur 33% der nötigen Informationen, der Rest wird durch Algorithmen „erraten“. Wie man aber sieht, erkennt man nur noch sehr wenige Unterschiede bei den fortschrittlichsten Algorithmen.

Eine weitere Methode, die sich OSC zur besseren Farbbestimmung zu Nutzen machen kann, ist der sogenannte Bayer Drizzle. Um Drizzle zu erklären, muss man zuerst wissen, was Dithering ist. Beim Dithering wird zwischen den einzelnen Aufnahmen die Ausrichtung des Teleskops durch die Montierung zufällig leicht verschoben, so dass z.B. ein Stern nun auf einen anderen Pixel fällt. Beim Drizzle werden in der Bearbeitung die Pixel der Bilder verkleinert. Man erhält dadurch ein feineres Pixelraster. Beim Stacken der Bilder erhält man durch die leicht verschobenen Aufnahmen Informationen im Subpixelbereich.

Diese Technik wurde für das Hubble-Weltraumteleskop entwickelt, um das Auflösungsvermögen des Teleskops voll auszunutzen. Astrofotografen machen sich dies auch zunutze. Die Methode verbessert Bilder, die Undersampling aufweisen. Aber auch Walking Noise, also Rauschen, welches in verschiedenen Aufnahmen immer gleich ist, wird durch die zufällige Verschiebung vermindert.

Bei OSC hilft Dithering, da z.B. rotes Licht, welches normalerweise ständig auf einen grünen Filter treffen und damit reflektiert werden würde, durch das leichte Verschieben nun auf einen roten Filter fällt, und damit vom Sensor aufgenommen werden kann. Durch den Bayer Drizzle erhält man so also für einen Pixel nicht nur Informationen von einer Farbe, sondern womöglich von allen drei Farben.

Durch moderne Algorithmen beim Debayering und durch Bayer Drizzle können viele Probleme der imperfekten Farbdarstellung bei OSC wettgemacht werden.

Komplexität

Durch die zusätzlich nötigen Geräte für Monokameras, wie ein elektronisches Filterrad und eventuell einen Fokussiermotor erhöht sich die Komplexität. Je mehr Geräte man verwendet, um Fotos zu machen, desto mehr einzelne Ausfallpunkte hat man. Dies betrifft nicht nur die Hardware, sondern auch die Software, die für das Zusammenspiel der einzelnen Komponenten verantwortlich ist. Durch die zusätzliche Komplexität erhöhen sich die Chancen auf Probleme zu stoßen, welche in der Nacht schwierig zu lösen sein können. Je länger man dann benötigt, um das Problem zu lösen, desto höher wird der Druck schnell eine Lösung zu finden, da wertvolle Aufnahmezeit verloren geht. Eine OSC verringert diese Komplexität. Mit weniger Problemen, die man zu bekämpfen hat, erhöht sich der Spaß an der Sache, was wichtig ist, fängt man erst mit der Astrofotografie an. Eine ganze Nacht damit zu verbringen, Probleme mit der Ausrüstung zu lösen, ist nicht sehr motivierend. Aber auch für Fortgeschrittene ist höhere Komplexität kein Muss.

Hat man jedoch mal ein funktionierendes System zusammengestellt, bei welchem alle Probleme ausgemerzt wurden und man vertraut mit den zusätzlichen Softwareeinstellungen ist, ist die höhere Komplexität kein Nachteil, sondern bietet mehr Optionen.

Schmalband

Hier punktet Mono. Mit Monokameras nutzt man verschiedene Schmalbandfilter, um planetarische Nebel, Supernovaüberreste und andere Emissionsnebel zu fotografieren. Durch die Filter kann es zu seltsamen Sternfarben kommen. Viele nehmen deshalb noch mit RGB-Filtern Bilder auf, um akkuratere Sternfarben zu erhalten.

Durch Dual Band Filter lassen sich auch mit OSC Schmalbandobjekte aufnehmen, jedoch muss man mit erhöhten Belichtungszeiten rechnen.

Aber auch ganz ohne jegliche Filter können mit OSC solche Objekte aufgenommen werden. Manche wählen absichtlich diesen Weg, um realitätsgetreuere Bilder zu erhalten. Diese würden dann eher dem entsprechen, was unsere eigenen Augen sehen würden. Auch das ist wiederum mit erhöhten Belichtungszeiten verbunden.

Mit beiden Typen ist die Aufnahme von Schmalbandobjekten möglich, Monokameras sind jedoch effizienter.

Breitband

Mono benutzt vier verschiedene Filter um Galaxien, Sternenhaufen und Reflexionsnebel aufzunehmen. Mit OSC braucht man keine zusätzlichen Filter. Mono ist womöglich etwas effizienter, OSC womöglich etwas realitätsgetreuer.

Andere Anwendungsgebiete

Mit Mono gestaltet sich die Aufnahme von Kometen kompliziert. Da sich Kometen vergleichsweise schnell am Nachthimmel bewegen, man aber trotzdem Bilder mit drei unterschiedlichen Filtern aufnehmen muss, ist die Verwendung einer OSC hier von Vorteil.

Kometen wie z.B. NEOWISE oder Hale Bopp haben einen zusätzlichen Kometenschweif, der aus dem Element Natrium besteht und somit eine Wellenlänge von 589nm ausstrahlt. Viele RGB Filter, die für Monokameras verwendet werden, haben genau bei dieser Wellenlänge einen Spalt, um das Licht von Natriumdampflampen zu blockieren. Benutzer von Monokameras mit solchen Filtern können einen Natriumschweif nicht aufnehmen.

Milchstraßenfotografie ist grundsätzlich mit beiden Typen möglich. Oft hat man bei Milchstraßenfotos jedoch auch Vordergrundelemente wie Berge oder Bäume. Für diese benötigt man eine OSC.

Auch für Planetenaufnahmen kann man beide Typen verwenden. Da Planeten aber rotieren, muss man mit Monokameras oft die Filter wechseln, um alle drei Farbkanäle aufzunehmen, bevor sich die Oberfläche des Planeten ändert. Zwischen den Filterwechseln muss erneut fokussiert werden. Dieser Aufwand lässt sich für viele nicht rechtfertigen, obwohl Planetenaufnahmen mit Mono etwas schärfer sein können.

Auch bei Mondaufnahmen gilt: Mono kann schärfer sein, will man jedoch Farbinformationen im Mondbild, ist eine Farbkamera bequemer.

Außer für Weißlichtaufnahmen, versucht man bei der Sonnenfotografie Hα aufzunehmen. Statt 3nm, wie in der Deep-Sky Astrofotografie, werden bei Solarbildern nur etwa 0,7 Angstrom des Lichts durchgelassen, was 0,07nm entspricht. Da in diesem Fall nur eine Wellenlänge aufgenommen wird, ist eine Monokamera überlegen. Eine OSC würde nur ein Viertel des Lichts aufnehmen.

Will man Nordlichter aufnehmen, empfiehlt sich definitiv eine OSC. Polarlichter ändern sich zu schnell, als dass man Filter wechseln könnte.

Auch für Startrail Bilder, also Strichspuraufnahmen, verwendet man normalerweise nur OSC.

Zusammenfassung

Farbkameras haben ein breites Anwendungsgebiet, für eine vergleichsweise geringe Investition. Ob Schmalband-, Breitband- oder jegliche andere erdenkliche Art von Astrofotografie – mit OSC ist alles ohne anfängliche Frustrationen möglich. Mit ständig besser werdenden Algorithmen und Programmen zur Schärfung und Rauschreduzierung, verringern sich die Unterschiede in Qualität zu Monokameras stetig. Nicht ohne Grund sind die meisten Astro-Kameras, die verkauft werden, Farbkameras.

Die bestmögliche Qualität und größte Effizienz erreicht man in fast allen Anwendungsgebieten mit Monokameras. Will man die letzten Details aus den Bildern holen und scheut sich nicht vor der Komplexität und den zusätzlichen Kosten, ist man mit einer Monokamera sehr gut bedient. Besonders bei Schmalbandaufnahmen zeichnen sie sich aus. Eine Monokamera ist auch sehr flexibel, will man beispielsweise mehr Daten von nur einem bestimmten Element sammeln.

Bei der Frage „Mono- oder Farbkamera?“ muss man am Ende selbst entscheiden, was besser für die eigenen Ziele geeignet ist. Keine der beiden Typen in allem überlegen, weswegen im Titel auch „Mono- und Farbkameras“ anstatt „Mono- vs. Farbkameras“ steht.

Ich hoffe, ich konnte etwas Licht in diese komplexe Thematik bringen und nicht nur die Unterschiede, sondern auch die jeweiligen Vor- und Nachteile beleuchten.

By Philipp Lechner